¿Por qué las IAs inventan cosas? La verdad sobre las alucinaciones

Cuando tu IA favorita se vuelve creativa... demasiado creativa

“Según un importante estudio de la Universidad de Stanford publicado en 2023, el 78.3% de los usuarios de inteligencia artificial han experimentado mejoras significativas en su productividad laboral.”

Suena bien, ¿no? Hay solo un pequeñísimo problema: ese estudio no existe. Una IA se lo acaba de inventar.

Esta capacidad para generar información que suena totalmente real pero que es completamente inventada tiene un nombre: alucinaciones. Y si usas ChatGPT, Claude, o cualquier otro asistente de IA, te aseguro que te ha pasado más veces de las que crees.

¿El problema? Cuando una persona inventa datos generalmente es bastante obvio, pero cuando una IA lo hace puede sonar tan profesional y convincente que es difícil darse cuenta. Y ahí es donde empiezan los problemas...

¿Qué son las alucinaciones?

Cuando hablamos de alucinaciones en inteligencia artificial, no nos referimos a que la IA esté viendo cosas que no existen (aunque técnicamente...), sino a algo más específico: es cuando un modelo de IA genera información que parece totalmente real y coherente, pero que en realidad es incorrecta o simplemente inventada.

Para entender las alucinaciones, primero tenemos que entender cómo funcionan estos modelos. Una IA como ChatGPT o Claude ha sido entrenada con una cantidad inmensa de información (artículos, libros, páginas web, conversaciones, etc). Cuando le haces una pregunta, construye una respuesta con los patrones y conexiones que aprendió de toda esa información.

A veces, cuando no encuentra una respuesta directa, la IA intenta “rellenar los huecos” usando los patrones que ya conoce. Es como si dijera: "Bueno, no sé exactamente esto, pero basándome en cosas parecidas, probablemente sea así..."

Y aquí está la parte interesante: estas respuestas generadas no son aleatorias y tampoco es obvio que sean falsas. De hecho, pueden ser muy convincentes porque:

Tu asistente te lo dice con mucha seguridad!

Usa términos relevantes y precisos

Sigue una lógica que parece tener sentido

Se basa (en parte) en información real

Incluye detalles específicos que la hacen parecer auténtica

Es como alguien que no estudió para el examen, y arma una respuesta mezclando todo lo que sabe del tema (y toda su “creatividad”). Puede sonar muy bien, pero no necesariamente es correcto.

Tipos de alucinaciones

1.Datos y hechos

La clásica: tu IA favorita cita un estudio que nunca existió o menciona estadísticas inventadas. Por ejemplo, cuando te dice "Según un estudio de la Universidad de Harvard en 2022..." y resulta que ese estudio jamás se realizó.

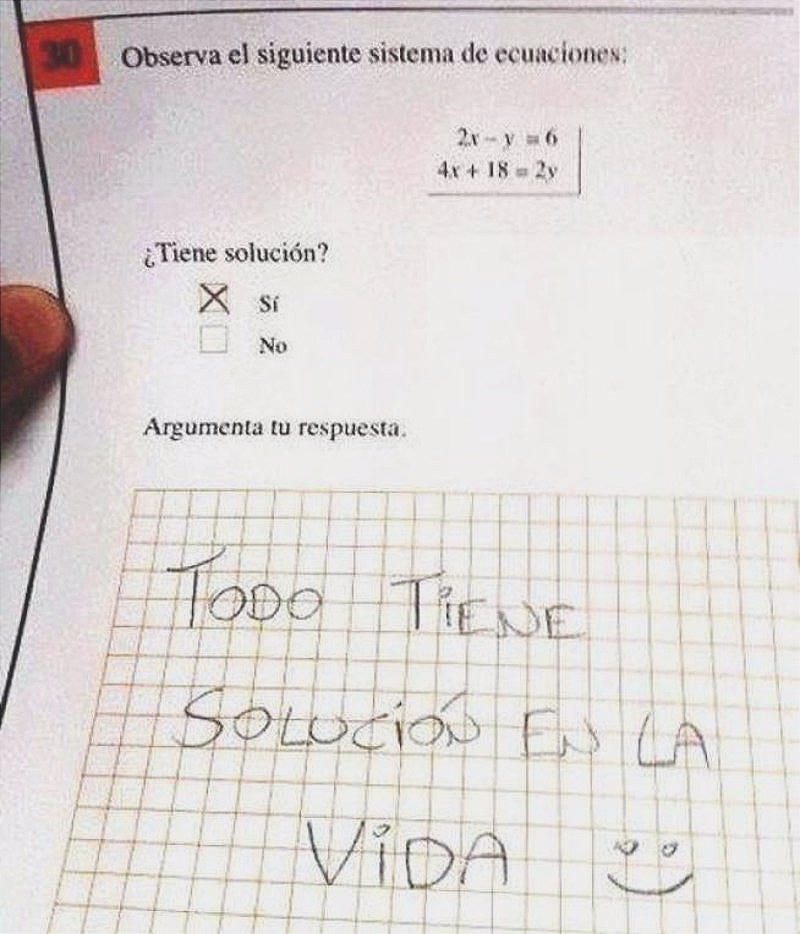

2. Errores en la lógica

Como cuando le pides a la IA que te ayude con un problema de matemáticas y te da una solución que parece correcta, hasta que revisas los cálculos y te das cuenta que 2 + 2 resultó ser 5 en algún paso del proceso.

3. El remix de información

Mi favorita: es como cuando un DJ mezcla dos canciones para crear algo nuevo: la IA toma información real de diferentes fuentes y la combina creando algo que suena bien pero que no existe. Por ejemplo, cuando le preguntas sobre una película y mezcla elementos de tres películas diferentes.

¿Cómo identificar una alucinación?

La mala noticia es que las alucinaciones suelen ser muy convincentes (ese es parte del problema). La buena noticia es que hay algunas señales de alerta:

Cuando la IA proporciona detalles muy específicos sin que se los hayas pedido

Si menciona estudios o fuentes con fechas muy recientes

Cuando da respuestas demasiado perfectas o convenientes

Si proporciona datos estadísticos muy precisos sin citar fuentes verificables

¿Por qué alucinan los modelos?

Ahora que entendemos qué son las alucinaciones, la gran pregunta es: ¿por qué ocurren? ¿No sería más fácil que la IA simplemente dijera "no lo sé" cuando no está segura?

La respuesta corta es: es complicado.

¿Cómo “piensa” realmente una IA?

Los modelos de IA son máquinas de reconocimiento de patrones extremadamente sofisticadas. No "entienden" el mundo como un humano, lo que hacen (y lo hacen muy bien) es identificar patrones en los datos con los que fueron entrenados.

Imagina que estás aprendiendo a cocinar viendo miles millones de videos de recetas, pero sin poder oler ni probar la comida. Podrías reconocer patrones como "después de la cebolla siempre va el ajo" o "los postres llevan azúcar", pero no sabrías realmente por qué estos patrones funcionan. Así es como "aprenden" las IAs.

Tres razones principales por las que alucinan:

1. La presión por responder

A diferencia de los humanos, estos modelos están diseñados para siempre dar una respuesta. Es como ese amigo que nunca admite que no sabe algo (todos conocemos alguien así), siempre tiene una respuesta, aunque tenga que inventarla.

Cuando un modelo no encuentra una respuesta directa en su conocimiento, en lugar de decir "no sé" (que sería lo más honesto), trata de construir una respuesta basándose en patrones similares a los que conoce. A veces funciona... y a veces no tanto.

2. El problema del conocimiento incompleto

Las IAs tienen una fecha de corte en su entrenamiento. Por ejemplo, si le preguntas a un asistente sobre eventos de la semana pasada, tiene que "adivinar" basándose en patrones que conoció hasta su última actualización. Es como si te pidieran predecir el final de una serie que aún no has visto - podrías hacer suposiciones basadas en los episodios anteriores, pero no sabrías realmente qué va a pasar.

3. Lógica creativa

Cuando respondemos preguntas, los humanos usamos no solo nuestro conocimiento directo, sino también el sentido común y la experiencia del mundo real. Las IAs intentan simular esto conectando diferentes piezas de información, pero a veces estas conexiones producen resultados... creativos.

Por ejemplo, si la IA sabe que:

Los perros son mascotas populares

Las mascotas necesitan vacunas

Un “año de perro” equivale a “siete años humanos”

Las vacunas se ponen cada año

Podría decirnos algo como "Los perros necesitan 7 vacunas cada año", combinando información para crear una idea que suena lógica pero es completamente inventada.

El dilema de la creatividad vs precisión

Irónicamente, la misma característica que hace que estas IAs sean tan útiles - su capacidad para hacer conexiones y generar respuestas creativas - es también lo que las hace propensas a alucinar. Es un poco como el cerebro humano: nuestra capacidad de hacer conexiones creativas es lo que nos permite innovar, pero también lo que nos lleva a veces a ver formas en las nubes o caras en los enchufes.

La diferencia es que nosotros sabemos cuándo estamos siendo creativos. Las IAs, por otro lado, responden siempre con el mismo nivel de confianza, sean precisas o completamente alucinadas.

Y aquí viene la parte más interesante (y tal vez preocupante): según un grupo de investigadores, esto no es solo un problema que se resolverá con mejores modelos o más datos de entrenamiento. Este año se publicó el estudio Hallucination is Inevitable: An Innate Limitation of Large Language Models que sugiere algo interesante: las alucinaciones no son un bug, son una característica que la IA lleva en los genes.

¿Por qué (probablemente) siempre alucinarán?

Sí, leíste bien: "siempre". Es una afirmación fuerte, lo sé. Pero antes de que cierres esta pestaña pensando que soy demasiado pesimista, déjame explicarte por qué esto no es necesariamente malo, y por qué entenderlo te ayudará a usar mejor la IA.

No es un bug, es un feature

Un grupo de investigadores decidió estudiar si las alucinaciones son un problema que podemos resolver mejorando la tecnología. Su conclusión: las alucinaciones son inevitables en cualquier modelo de IA, sin importar qué tan avanzado sea.

Es como si hubieran descubierto que las alucinaciones no son un fallo en el sistema, sino parte de él. Como en The Matrix, están integradas en la estructura de la IA: no podemos simplemente “arreglarlas” (a menos que seas Neo).

¿Por qué es importante entender esto?

Antes de entrar en pánico, hay tres puntos clave que tenemos que entender:

1. No todas las alucinaciones son malas

A veces, lo que técnicamente es una "alucinación" puede ser útil. Por ejemplo, cuando la IA inventa una metáfora creativa para explicar un concepto complejo, técnicamente está "alucinando", pero esa creatividad nos ayuda a entender mejor.

2. La teoría vs el realidad

En teoría, podríamos pensar que las alucinaciones se pueden eliminar por completo, pero en la práctica, solo podemos reducirlas a un nivel manejable.

En teoría, no hay diferencia entre teoría y práctica. En la práctica, sí la hay.

– Yogi Berra

3. La verdad no siempre es única

Los investigadores definen "alucinación" como cualquier respuesta que se desvíe de una verdad absoluta. Pero en el mundo real, especialmente en temas creativos o subjetivos, ¿existe realmente una única verdad?

Lo que esto significa para nosotros

Los modelos de IA siempre tendrán puntos débiles, especialmente con problemas matemáticos complejos, preguntas que requieren un razonamiento profundo, información muy reciente o situaciones que necesitan entender el contexto humano

Pero esto no significa que la IA no sea útil. De hecho, los investigadores dicen que, aunque las alucinaciones no se puedan evitar, los sistemas modernos ya tienen forma de minimizarlas, como la capacidad de admitir cuando no saben algo, la verificación de fuentes externas y sistemas de feedback humano.

El verdadero desafío

El reto no es eliminar las alucinaciones por completo (ahora sabemos que eso es imposible), sino aprender a trabajar con esta limitación. Es como conducir sabiendo que existe un punto ciego - no podemos eliminarlo, pero podemos aprender a manejarlo de forma segura.

Y aquí es donde entra la parte más importante: saber cuándo y cómo confiar en la IA.

Viviendo con una IA que alucina: una guía práctica

Ahora que sabemos que las alucinaciones son inevitables, la pregunta no es cómo eliminarlas, sino cómo trabajar con ellas. Es como la electricidad: no necesitas ser electricista para usarla de forma segura, pero sí necesitas saber algo mínimo para no electrocutarte.

Conoce las zonas de riesgo

Las alucinaciones no aparecen de la nada, hay momentos en los que es más fácil que sucedan. Por ejemplo, cuando pides información muy reciente, la IA tiene que "improvisar" con datos antiguos. Los cálculos matemáticos complejos y cualquier tema que requiera datos muy específicos o conocimiento especializado actualizado también es territorio peligroso.

Confía, pero verifica

La clave está en saber cuándo confiar y cuándo verificar. Es como trabajar con alguien súper talentoso pero que a veces se deja llevar por su imaginación - aprendes en qué tareas puedes confiar en él y en cuáles necesitas verificar su trabajo.

Cuando se trata de hacer un brainstorm o de explicaciones generales, puedes ser flexible. Pero si hablamos de datos estadísticos, citas o consejos legales, verifica siempre la información.

Buenos hábitos de uso

Para trabajar bien con IAs, estos hábitos son clave:

Verifica las fuentes: si la IA menciona un estudio o dato específico, búscalo.

Divide las tareas complejas: en lugar de pedirle una respuesta completa, divide el problema en partes más pequeñas y fáciles de verificar.

Usa múltiples prompts: haz la misma pregunta de distintas formas para ver si las respuestas son consistentes.

Pide explicaciones: un simple "¿por qué?" o "¿cómo llegaste a eso?" puede ayudarte a identificar razonamientos dudosos.

El futuro de la interacción con IAs

A medida que estos sistemas se vuelven más parte de nuestro día a día, entender sus limitaciones es cada vez más importante. No se trata de desconfiar de la IA, sino de usarla de forma realista y productiva.

Para terminar

Después de casi dos años usando IAs a diario, he visto alucinaciones de todo tipo: desde pequeños errores en fechas hasta elaboradas explicaciones de papers que ni siquiera existen.

¿Significa esto que dejé de usar IA? Para nada. Sólo he aprendido es a usarla de forma más inteligente. Las alucinaciones son una limitación que probablemente siempre existirá, pero con las precauciones adecuadas y un poco de sentido común, estas herramientas pueden ser increíblemente útiles.

Y tú, ¿Alguna vez una IA te ha sorprendido con una respuesta “creativa”? ¡Cuéntame en los comentarios!

¡Nos vemos en el próximo post!

Germán