Humanizando a la IA

¿Por qué nuestro cerebro insiste en tratar a los asistentes de IA como si fueran humanos? Spoiler: por la misma razón que le ponemos nombre a nuestra aspiradora.

"Mil gracias, Claude!"

Escribí esto y me quedé mirando la pantalla. Acababa de agradecerle a un software.

Imagínate que al sacar una tostada, le dijeras a tu tostadora: "Excelente trabajo, señora Tostadora!". Cualquiera pensaría que estás loco (pero quién soy yo para juzgar). La verdad es que casi todos nosotros hablamos con estos asistentes como si fueran humanos, y tiene sentido, después de todo usan nuestro idioma y tienen nombres familiares como Siri, Alexa o Claude… y hmmm... ¿ChatGPT?.

Llevo casi 20 años trabajando en tecnología, y he leído un montón sobre la interacción humano-computadora (HCI) e interfaces conversacionales –disculpa los tecnicismos, prometo que no lo vuelvo a hacer– así que entiendo por qué pasa esto. Lo interesante es que por más que lo entienda lo sigo haciendo...

Déjame contarte qué hay detrás de esto.

¿Por qué le ponemos nombre a nuestras aspiradoras?

En casa tuvimos una aspiradora robot que llamamos Aníbal (no preguntes por qué). Cuando Aníbal se quedaba atascado debajo de un mueble o se le ocurría atorarse con una alfombra, nadie decía "la aspiradora está atorada". Decíamos: "Aníbal necesita ayuda". Para mis hijos, era prácticamente un miembro más de la familia, aunque siempre bromeábamos sobre lo poco inteligente que era.

Y no soy el único. ¿Quién no le ha gritado "vamos, funciona!" a su impresora? (es el 2025 y estos aparatos siguen igual de fastidiosos que hace una década) ¿Y cuando la computadora se cuelga y no guarda ese documento importante… nunca se lo has reclamado?

Tratar a las cosas como si tuvieran personalidad no es algo raro o nuevo. Es resultado de cómo está diseñado nuestro cerebro.

Durante millones de años, nuestros antepasados sobrevivieron porque estaban siempre alerta. Si escuchabas un ruido en el bosque, era mucho más seguro pensar "hay un tigre que me quiere comer" que "seguro no es nada". Los que se imaginaban peligros, aunque no existieran, vivían para contarlo. Los que no... bueno, no dejaron descendencia.

Ese cerebro prehistórico sigue con nosotros –Darwin estaría asintiendo con aprobación– ver “algo” donde no hay nada nos ayudó a sobrevivir. Y es por eso que vemos caras en los enchufes (¿lo has notado?), renegamos con la impresora, y hablamos con las plantas. Ademas, lo hacemos sabiendo que son sólo objetos.

Quienes diseñan las IA conocen perfectamente este punto débil de nuestro cerebro y lo explotan al máximo.

No te presentan un “sistema”, les ponen nombre.

Les dan voz.

Les enseñan a responder con pausas para que parezca que están pensando.

Incluso te dicen cosas como "me equivoqué" o "tienes razón", que no son necesarias para que funcione, pero sí para que te caiga bien.

Y funciona. Porque aunque sepas que no es una persona, tu cerebro cree que sí.

Ahora, este pequeño quirk en nuestra mente, tiene efectos mucho más grandes de lo que imaginas… y no solo en cómo vemos a las máquinas, sino también en cómo nos responden.

¿Hay que ser amable con la IA?

Hace poco encontré un estudio que me dejó pensando. Unos investigadores de la Universidad de Waseda en Japón se preguntaron ¿el tono con el que le hablas a una IA afecta la calidad de sus respuestas?

Resulta que, según el estudio, cuando tratas bien a una IA, te da mejores respuestas.

Hicieron pruebas en varios idiomas y probaron diferentes formas de hablar (de más amables a más secas). Lo que descubrieron fue que cuando le hablas bonito a la IA, te da respuestas más completas y útiles. En cambio, si le hablas feo o de mala manera, la calidad de lo que te responde baja.

Pensemos en esto por un momento. La IA no tiene sentimientos que puedan herirse (aún). No se va a poner triste si eres brusco. Entonces, ¿por qué pasa esto?

La respuesta está en cómo se entrenan estos modelos. Aprendieron de millones de conversaciones humanas donde, las preguntas hechas de buena manera reciben mejores explicaciones.

Es como si la IA hubiera absorbido una regla básica de la comunicación humana: si eres amable, es más probable que te respondan bien. Nunca fue programada para eso, sólo aprendió el patrón de los datos.

Y es gracioso como, al final, terminamos diseñando sistemas que siguen nuestros códigos sociales porque aprendieron viendo cómo nos tratamos entre nosotros. ¿No es así como aprende un niño?

En lo que respecta a mi, me encantó saber que mi instinto de tratar bien a Claude no era solo mi tendencia a humanizar la tecnología, también resultó ser la forma más efectiva de conseguir buenas respuestas.

Además, tratar bien a estos asistentes no caerá mal cuando Skynet tome el control 😉

Bueno, ahí estaba yo, feliz con mi teoría de “sé amable y la IA te tratará mejor”… hasta que me topé con algo que me zamaqueó el cerebro

El problema con tratar bien a la IA

Confieso que, a veces, he tratado muy mal a ChatGPT*. Hablar con él todo el día y que no me entienda o que me responda cualquier cosa, me ha hecho decirle algunas cosas subidas de tono (que no pienso repetir aquí). Hoy, ya reconciliados, trato de ser siempre amable con él.

Vivía tranquilo creyendo que no sólo estaba a salvo de Skynet, sino que además recibía mejores respuestas por tratarlo con amor… hasta que vi una noticia que me bajó de la nube.

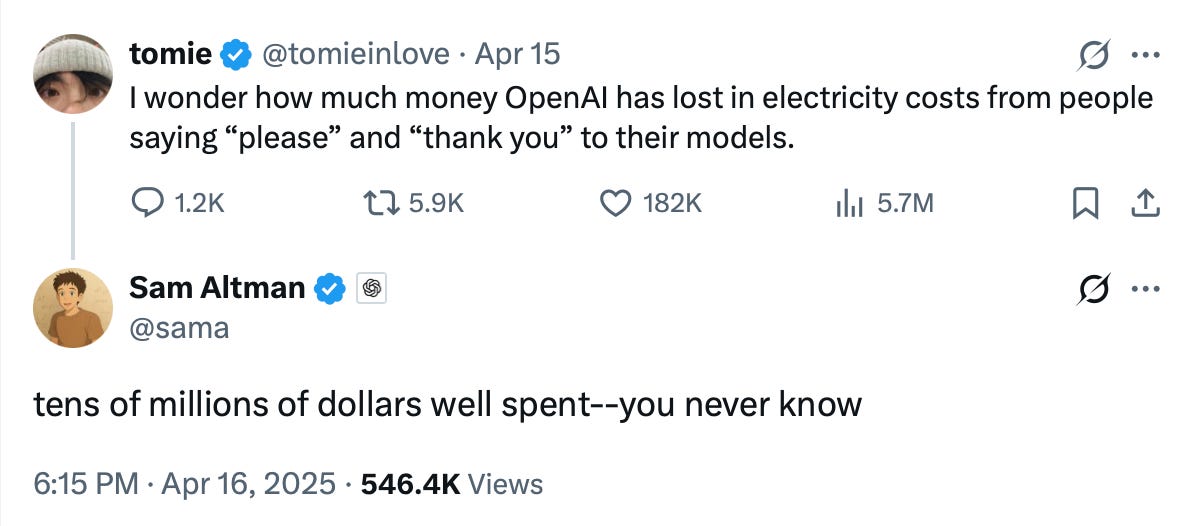

Un usuario en Twitter se preguntó ¿Cuánto dinero pierde OpenAI en electricidad por la gente que le dice “por favor” y “gracias” a ChatGPT?

Lo que no se esperaba era que Sam Altman, el fundador de OpenAI, le respondiera diciendo que eran decenas de millones de dólares.

Sí, leíste bien. Decenas. De. Millones. De. Dólares.

¿Todo ese gasto sólo por ser educados con la IA? Al principio suena exagerado, pero cuando ves cómo funciona por dentro… comienza a tener sentido.

Cada palabra (o mejor dicho, cada token, que es como la unidad mínima que la IA entiende) necesita ser procesada. Y eso significa mover muchas piezas: servidores, ventilación, electricidad. Cuando escribes"muchas gracias por tu ayuda" la IA tiene que procesar esos tokens. Nada es gratis.

Los centros de datos donde viven estos modelos funcionan 24/7/365, y consumen una cantidad brutal de electricidad, claro que una sola conversación no gasta mucho, pero cuando lo multiplicas por millones de personas hablando con la IA todos los días, la cosa cambia.

Y no es solo electricidad. Para que esta tecnología no explote –en el sentido literal– necesita estarse enfriando todo el tiempo, y eso implica usar muchísima agua (por ahí leí que usa medio litro de agua por cada 100 palabras). En un mundo donde el calentamiento global y la crisis de agua es un tema urgente no podemos ignorar esto.

Así que cada vez que escribo un "por favor" o cierro con un "muchas gracias", por más inofensivo que parezca, estoy usando energía, agua, y contribuyendo (aunque sea un poquito) al cambio climático.

Y acá es donde todo se empieza a enredar.

Por un lado, ser amables con la IA mejora las respuestas. Por otro, cada palabra extra tiene un impacto real en el medio ambiente. Y encima, nuestro cerebro de reptil trata de humanizar estas herramientas, así que nos sale natural tratarlas con cariño.

Investigar y leer sobre estos temas me ha hecho sentir una tensión que me es difícil de explicar, es como si la empatía, la eficiencia y la responsabilidad ambiental tiraran para lados distintos cada vez que hablamos con un asistente de inteligencia artificial.

¿Qué deberíamos priorizar? ¿Vale la pena gastar más recursos para tener mejores respuestas? ¿O conviene ser más directos con algo que, al fin y al cabo, no tiene sentimientos?

¿Y ahora qué? Mi dilema con la IA

Cuando empecé a escribir este post, solo quería entender por qué me sentía raro agradeciéndole a Claude. Ahora estoy en medio de un dilema existencial.

Mi cerebro insiste en tratar a la IA como si fuera humana.

Ser amable realmente mejora las respuestas.

Cada “por favor” y “gracias” consume energía y agua que, a gran escala, impacta de forma negativa en el planeta

No es fácil balancear esas tres cosas. Cada vez que hablo con un asistente, tengo esa sensación de estar eligiendo entre lo que me sale natural, lo que funciona mejor y lo que consume menos.

La verdad es que no tengo una respuesta. Sigo ajustando la forma en que trabajo con estos sistemas. A veces soy más directo, otras más conversacional. En ocasiones le doy las gracias a ChatGPT... y luego me acuerdo de la paradoja energética.

Lo que sí tengo claro es que estas pequeñas interacciones con la IA dicen mucho sobre nosotros mismos. Sobre cómo funciona nuestro cerebro, qué valoramos cuando conversamos, y qué estamos dispuestos a ceder entre comodidad y responsabilidad.

Seguramente iré cambiando de opinión sobre esto con el tiempo (como cualquier humano), pero sentía que tenía que compartir estas reflexiones.

Quizás la próxima vez que le digas “gracias” a ChatGPT o a Claude, te detengas un segundo a pensar en todo lo que hay detrás de ese simple gesto… o tal vez lo digas de todas formas, al final, ser amable es parte de lo que nos hace humanos, incluso cuando hablamos con máquinas.

Abrazo,

G

* Un amigo fue testigo de alguna vez que traté feo a ChatGPT en medio de una reunión de trabajo. Tal vez algún día escriba sobre eso, si Robert me deja entrevistarlo.

Gran artículo Germán y cuando quieras tenemos la entrevista, solo ten al alcance bastante agua fría para que se pueda procesar todo lo relacionado al anécdota. Abrazo