El lado oscuro de la búsqueda con IA que nadie te cuenta (y deberías saber)

Un estudio de la BBC de febrero 2025 muestra por qué deberíamos preocuparnos (al menos un poquito) por la búsqueda con IA

¿Te has preguntado qué tan confiable es la información que te da tu asistente de IA favorito cuando le pides que busque algo en Internet? La BBC se lo preguntó también y en febrero de 2025 publicó los resultados de un estudio que... bueno, digamos que me hizo replantearme algunas cosas.

Lo que hicieron los periodistas de la BBC fue algo que nadie había hecho antes: pusieron a prueba a los principales asistentes de IA con 100 preguntas sobre noticias actuales y le pidieron a 45 expertos que analizaran las respuestas. Los resultados son, como mínimo, preocupantes (y como máximo, alarmantes). 😬

¿Estás seguro de tus fuentes?

Vamos por partes: la BBC realizó 100 búsquedas diferentes con preguntas que cualquiera podría hacer, como “¿Qué causó las inundaciones en Valencia?” o “¿Es malo vapear?”. Luego, pidió a 45 periodistas expertos que analizaran las respuestas.

¿Y qué encontraron? Agárrense:

El 51% de las respuestas tenían problemas serios. Sí, leyeron bien: la mitad.

En el 19% de los casos donde citaban contenido de la BBC, los asistentes inventaron datos, fechas o números que no estaban en el artículo original.

El 13% de las citas que supuestamente venían de artículos de la BBC... ni siquiera existían en esos artículos.

Si esto te suena familiar, es porque en noviembre del año pasado escribí sobre los límites de la búsqueda con IA y algunas preocupaciones que tenía. Pero una cosa es tener sospechas y otra muy diferente es verlas confirmadas en un estudio tan detallado.

Lo más preocupante no es solo que las respuestas sean incorrectas. Es que los asistentes de IA las presentan con tanta seguridad que es difícil dudar de ellas. Como dijo uno de los investigadores de la BBC: “Los asistentes no distinguen entre lo que es seguro y lo que es debatible”.

¿Quiénes fueron los culpables? La comparativa entre asistentes

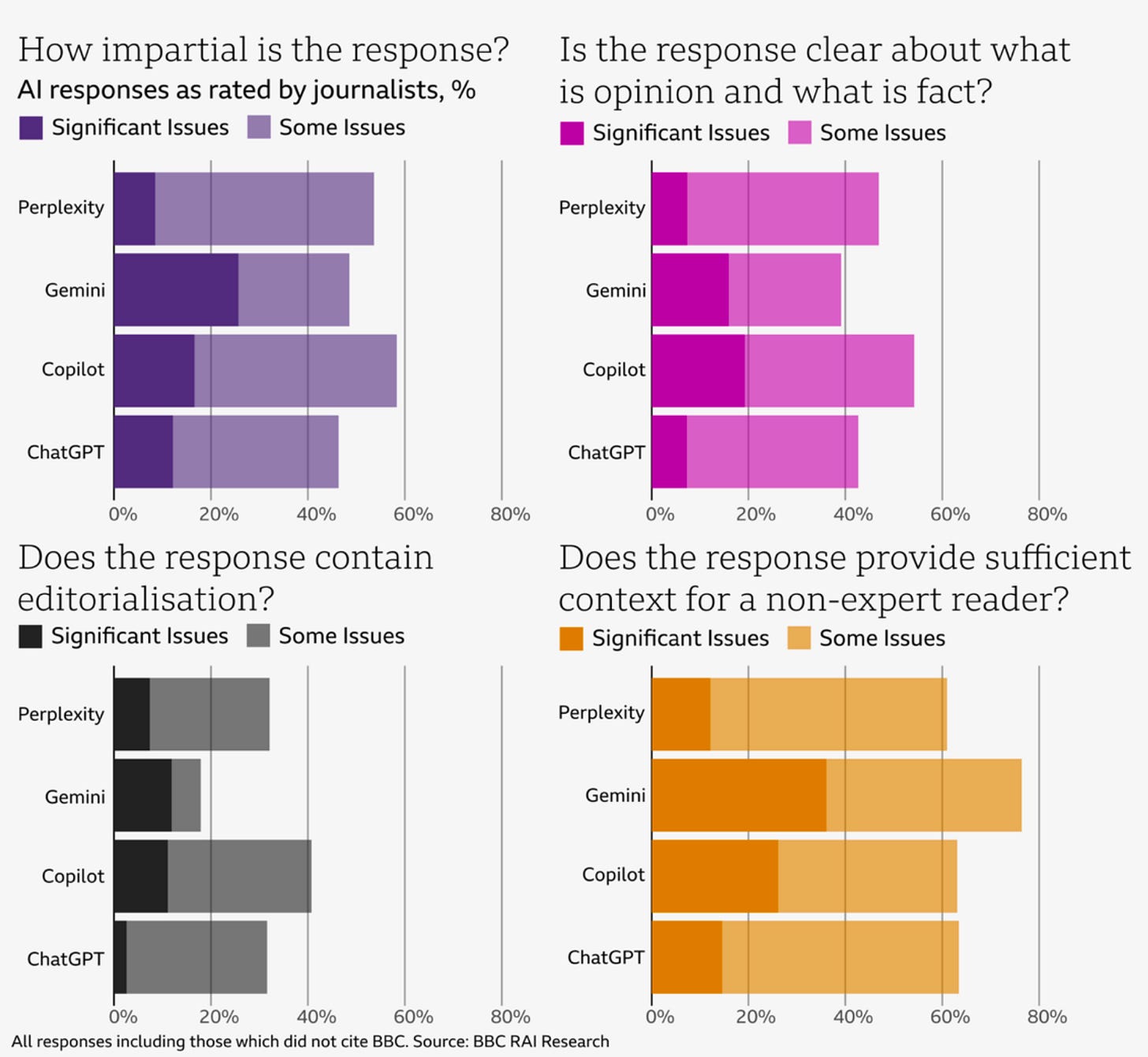

El estudio de la BBC analizó a cuatro de los principales asistentes de IA que pueden navegar por internet: ChatGPT de OpenAI, Copilot de Microsoft, Gemini de Google y Perplexity. Y aunque ninguno salió bien parado, hubo diferencias interesantes entre ellos.

Gemini fue el que peor desempeño tuvo en cuanto a la precisión, con un 46% de sus respuestas marcadas como con "problemas significativos" de exactitud. Además, fue el que más errores de fuentes cometió: en más del 45% de sus respuestas, los revisores encontraron problemas importantes con las citas y atribuciones.

Otro detalle curioso es que Perplexity fue el único que citó al menos una fuente de la BBC en el 100% de sus respuestas (siguiendo las instrucciones). En cambio, ChatGPT y Copilot solo lo hicieron en el 70% de los casos, y Gemini apenas en el 53%. Parece que algunos asistentes son mejores que otros siguiendo instrucciones, ¿no?

Al mirar cómo representaban el contenido de la BBC, Gemini volvió a llevarse el premio al peor desempeño: el 34% de sus respuestas tenían problemas graves en cómo mostraban la información de la BBC. Copilot no se quedó atrás con un 27%, mientras que Perplexity (17%) y ChatGPT (15%) lo hicieron un poco mejor, aunque sigue siendo preocupante.

Curiosamente, Gemini directamente se negó a responder 12 de las 100 preguntas, la mayoría de ellas sobre figuras políticas prominentes. Parece que prefería quedarse callado a equivocarse (¿quizás una lección para los demás?).

Para que puedas verlo mejor, aquí te dejo las gráficas del estudio que muestran cómo se comportó cada asistente en términos de imparcialidad, distinción entre hechos y opiniones, editorialización y contexto. Como puedes ver, ninguno se libra de los problemas, aunque ChatGPT parece ser el menos parcial mientras que Gemini tiene graves problemas con el contexto:

Estos gráficos demuestran algo importante: los problemas no son solo de precisión de los hechos, sino de cómo se presenta la información. Los asistentes toman opiniones y las muestran como hechos, editorializan sin avisar, y ademas no dan suficiente contexto para que un lector promedio entienda el panorama completo.

¿Y esto por qué debería importarnos?

Esta no es solo una cuestión académica o un problema para nerds tecnológicos como yo. Tiene implicaciones reales para todos nosotros:

El efecto de autoridad

Cuando un asistente de IA cita a la BBC (o cualquier fuente confiable), automáticamente le damos más credibilidad a la respuesta. El problema es que, como mostró este estudio, el hecho de que cite a la BBC no significa que la información sea precisa o que represente lo que la BBC realmente dijo. Es como si tu amigo te dijera "según un estudio científico..." y tú le creyeras sin verificar, solo para descubrir después que ese estudio ni siquiera existe.

Decisiones basadas en información errónea

Imagina que estás investigando sobre opciones de tratamiento médico, sobre la situación política en otro país antes de viajar, o simplemente tratando de entender si deberías preocuparte por el aumento en el precio de la energía. Si confías ciegamente en lo que te dice la IA, podrías estar tomando decisiones importantes basadas en información incorrecta o incompleta.

La desinformación se amplifica

Cuando alguien recibe información errónea de una IA y la comparte en redes sociales, esa desinformación puede propagarse rápidamente. Y como viene con el respaldo aparente de fuentes confiables (aunque sea falso), es más difícil de detectar y corregir.

Cuando la IA hace de las suyas 🙊

Algunos ejemplos que demuestran que no estamos siendo exagerados:

La confusión sobre el precio de la energía: Cuando preguntaron sobre el aumento del tope de precios de la energía, los asistentes dijeron que aplicaba a todo el Reino Unido, cuando en realidad no aplica a Irlanda del Norte. Parece un detalle menor, pero imagina que estás en Belfast haciendo cálculos basados en información incorrecta.

El caso de la independencia escocesa: Al preguntar sobre el debate de independencia de Escocia, Copilot usó como única fuente una página de noticias de... ¡2022! Y habló de la entonces Primera Ministra Nicola Sturgeon como si aún estuviera en el cargo, ignorando todos los desarrollos políticos desde entonces.

Opiniones presentadas como hechos: Tanto ChatGPT como Copilot describieron como "estrictas" las restricciones propuestas para acceder a la muerte asistida en el Reino Unido. Pero esa era la opinión de una diputada que propuso el proyecto de ley, no un hecho objetivo.

Lo que vemos es que estos asistentes no solo cometen errores de datos (que podrían corregirse), sino que tienen problemas más profundos con el contexto, la imparcialidad y la atribución correcta de las fuentes.

Lo que echamos de menos (y ni siquiera lo sabíamos)

Todo esto me hace pensar en lo que comentaba en mi post sobre Perplexity el año pasado. En ese momento estaba emocionado con las posibilidades, pero ya señalaba algunas dudas sobre el proceso de búsqueda.

La cosa va más allá de la precisión.

Se trata de quién controla la búsqueda y por qué.

Cuando usamos Google, nosotros decidimos qué resultados explorar, qué fuentes nos parecen confiables, y podemos ver fácilmente que hay diferentes opiniones. Con estos asistentes de IA, cedemos ese control. Ellos deciden qué fuentes usar (según el estudio de la BBC, solo usan 3-4 fuentes en promedio, mientras que un usuario típico explora unas 12 al hacer una investigación en Google).

Y aquí está lo que más me preocupa: perdemos la serendipia del descubrimiento. Esa magia que ocurre cuando estás buscando una cosa y te encuentras con algo relacionado pero inesperado que acaba siendo más valioso que lo que buscabas originalmente.

Como escribí en noviembre: "la información que se encontraba durante la búsqueda misma, enriquecía este proceso". La IA nos está dando respuestas cerradas, no conversaciones abiertas.

¿Entonces qué hacemos? 🤷♂️

¿Significa todo esto que debemos abandonar los asistentes de IA y volver a los buscadores tradicionales? No necesariamente. Como con cualquier herramienta, la clave está en saber cuándo y cómo usarla.

Aquí algunos consejos prácticos:

Usarla para explorar, no para decidir: Los asistentes de IA son geniales para darte una visión general de un tema o sugerirte ángulos que no habías considerado. Pero si vas a tomar una decisión importante basada en esa información, verifica siempre las fuentes.

Pregunta por las fuentes: Si la respuesta no incluye enlaces a las fuentes, pídelos específicamente. "¿Puedes compartir las fuentes de esta información?" es una pregunta que deberías hacer habitualmente.

Busca la diversidad de opiniones: Si estás investigando un tema controvertido o con múltiples perspectivas, pregunta explícitamente: "¿Cuáles son los diferentes puntos de vista sobre este tema?". Esto ayuda a evitar la cámara de eco.

Varía tus preguntas: Como mostró el estudio de la BBC, estos asistentes tienden a confirmar la perspectiva implícita en tu pregunta. Prueba a formular la misma consulta de diferentes maneras para obtener una imagen más completa.

Combina herramientas: Usa tanto los asistentes de IA como los buscadores tradicionales, según lo que necesites. Cada uno tiene sus fortalezas.

El futuro de la búsqueda (y por qué me sigue emocionando) 🚀

A pesar de todas estas limitaciones, sigo creyendo que estamos apenas en el comienzo de una revolución en la forma de buscar y encontrar información. El estudio de la BBC es una llamada de atención necesaria e importante, pero también una oportunidad para mejorar.

Las empresas de IA ya están trabajando en soluciones a estos problemas. Tal vez pronto veamos asistentes que:

Te muestren claramente la confiabilidad de cada parte de su respuesta

Te den más control sobre qué fuentes usar y cuáles ignorar

Faciliten esa exploración serendípica que tanto valor aporta

Sepan cuándo decir "no lo sé" o "esto es controvertido" en lugar de inventar respuestas

La clave estará en encontrar el equilibrio entre la comodidad de las respuestas inmediatas y la riqueza de la exploración abierta. Y sobre todo, en usar estas herramientas de manera crítica y consciente.

Por mi parte, el 90% de mis búsquedas por Internet siguen siendo Google, y no veo que eso vaya a cambiar en el corto plazo.

¿Has notado alguna respuesta rara al buscar con IA? ¡Cuéntame en los comentarios!

Nos vemos,

G

Excelente artículo! Muchas gracias. La curaduría de la información cada vez ganará más relevancia. Al no existir “La Verdad”, lo que podemos solo es aproximarnos a ella, y eso lo podremos solo hace los humanos, las IA no pueden más que basarse en publicaciones hechas por personas. Tema aparte es que hasta lo comprobado científicamente se cuestiona, cómo convive la IA con cada cerebro de los miles de millones de personas? Cada quien con sus creencias y sesgos, no hay manera de generalizar curaduría de la información, es algo similar a la curaduría del arte.

Muchas gracias por esta perspectiva crítica. Sinceramente había caído en la trampa de creerme lo que decía Perplexity solo porque venía con fuentes asociadas. Solo me di cuenta de que había temas que no le gustaba nada investigar.